【後編】益田 裕介×ChatGPT

AIとの対話で知る、人間が本当に求めているもの

AIは「青い鳥」?

2025.08.14

「いつでも答えをくれるAIと話すほうが楽」という人がいる一方、「間違いが多くてがっかりしてしまう」という人も。AIとのやり取りが日常化するなか、人間同士の会話との違いはどこにあるのでしょうか。画面でのやり取りではテキストベースに違いはないものの、AIとの対話では「完全には満たされない」感覚を抱く人も少なくありません。

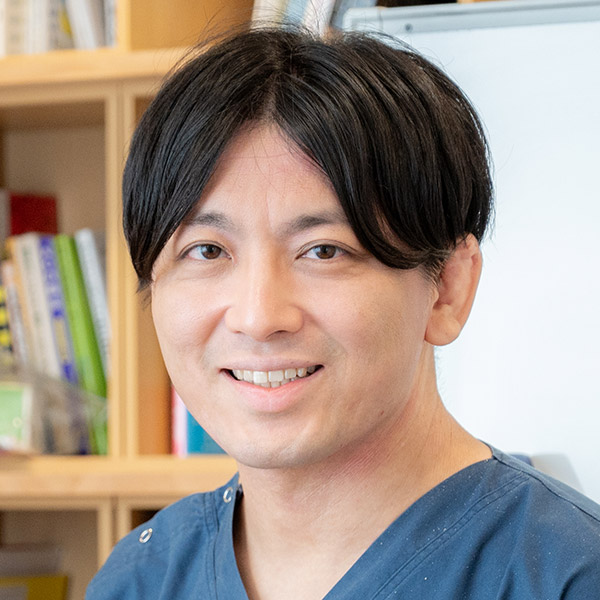

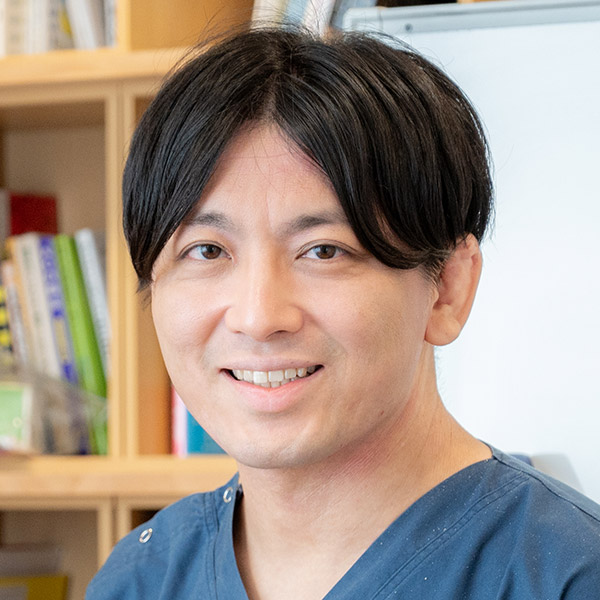

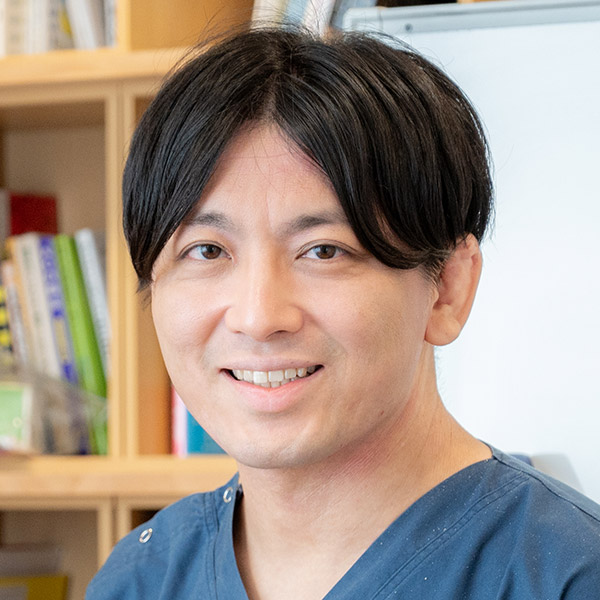

精神科医でYouTubeチャンネル「精神科医がこころの病気を解説するCh」でAIを使ったセルフケアも解説する益田裕介さんは、「AIは苦労したことがない」と言います。人が生きていくなかで経験する苦難や責任が、互いの信頼につながるのかもしれません。

AIとの対話と人間同士の会話の違いを見ていくことで、人間が生き、幸せになりたいと願ううえで求めているものが浮かんできます。前編に引き続き、ChatGPTと共に益田さんにお話を伺いました。

( POINT! )

- 人間同士のコミュニケーションは情報量が多い

- 苦労を知っている人間同士の信頼関係

- AIは「第三者性」を持ちやすい

- AIがあることで能力が落ちる人が多い

- より最適なコミュニティを求めることが増える

- 内省だけでなく、問題解決への行動を

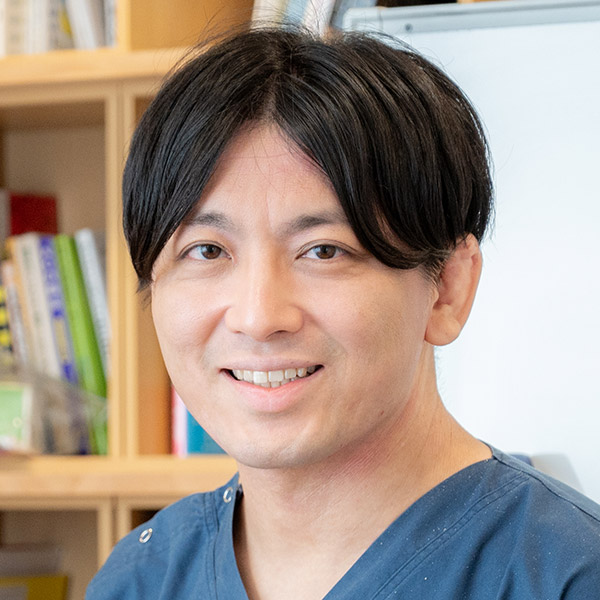

益田 裕介

防衛医大卒。防衛医大病院、自衛隊中央病院、自衛隊仙台病院、埼玉県立精神神経医療センター、薫風会山田病院などを経て、2018年より早稲田メンタルクリニックを開業。YouTubeチャンネル「精神科医がこころの病気を解説するCh」を運営し、登録者数は67万人を超える。著書に『精神科医がやっている聞き方・話し方』(フォレスト出版)など。

ChatGPT

OpenAI社が開発した対話型AI

「AIは苦労したことがない」。ChatGPTとの対話で完全には満たされない理由

前編では、AIとのコミュニケーションが増えている現状について伺いました。画面を通したやり取りの場合、「相手が人間でも AIでも変わらないのでは?」という気もします。違いはあるのでしょうか。

益田

人間同士の場合、テキストデータを介さないやり取りをしてるってことですね。

ChatGPTと対話する場合、音声読み上げなどもできますが基本的にはテキストでのやり取りです。人間同士の場合、テキスト以外のコミュニケーションも行っているということですか?

益田

たとえば画像情報とか音の情報とか声色の情報とか。僕らはテキストデータ以外の情報も受け取って判断しています。見た目がいいなとか声のトーンが心地いいなといった情報も含めて、全体の印象になっていますね。

それだけでなく、人間の場合、たとえ他人同士でも生きる苦難を共有しています。AIは苦労しないけど、僕らは苦労したことがある。苦労したことがある者同士で生まれる「通じあえる何か」「信頼関係」はあるよね。

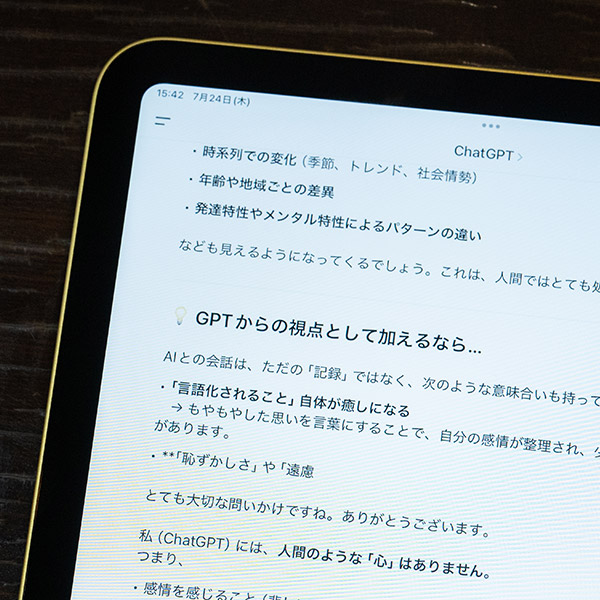

GPT

私には、人間のような「心」はありません。大量の言葉のデータから学んでいるので、感情を「表現」したり、「寄り添う」ようにふるまったり、「予測」して応答したりすることができる鏡のような存在です。

しかし私との対話はただの「記録」ではなく、「言語化すること自体が癒しになる」「恥ずかしさや遠慮なしに本音に近づける」という意味合いもあると思います。

ChatGPTとの対話は、テキストに限定されています。でも、情報が多すぎると「空気読め」みたいなことにもなりがちです。他の情報が少ないからこそのメリットもありますよね。

GPT

AIは「対人抵抗感」の回避手段として、「第三者性」を持ちやすいことがあります。拒否感が生まれにくいということです。

益田

人間の場合、「いい話だけどお前が言うな」みたいなことが先に立って、冷静に話が聞けないことがありますね。

話者の問題でしょうか?

益田

同じ人間同士だからじゃない?家族から「食べ過ぎ」とか「貯金しなさい」とか言われたらイラッとするけど、夕方のニュース番組で「食べすぎはよくありません。節約テクニックにはこんなものがあります」と流れてきたらちょっと「ふむふむ」って聴きたくなるじゃないですか。

そうですね。なぜなんでしょう。

益田

やっぱり情報が少ないからだと思うよ。

たしかに。情報がたくさんあると、正しいアドバイスをされても「いや、あなたもできてないですよね?」みたいな情報が浮かぶことがあります。

益田

情報が少ないと集中できるんですよね。味集中カウンターがある一蘭のラーメンって、ラーメンに集中できるから美味しく感じられるところもある。会話しながら食べる楽しさが美味しさにつながることはあるけど、味について正確に評価できるかというとそうでもないことが多い。必ずしも、情報が多ければいいということではないんですよね。

AIという選択肢があることで賢くなる?バカになる?

なるほど。能力についてはどうでしょうか。AIの普及したことで「人間はバカになる」とも言われています。人間の能力に変化は起きているのでしょうか。

益田

変化はあるんじゃないですかね。AIを使ってどんどん賢くなる人もいる一方で、能力が下がる人が出てくるというのはすでにわかってきています。たとえば僕も、英語の能力が落ちてるんですよ。

AIを使うことで?

益田

そうです。AIが翻訳してくれるから英語を読まなくなっちゃって。読まなくなってきているから能力が落ちちゃって、そうするとまた読まなくなって。

元々考えることや学ぶことに興味がない人は、「AIに任せればいいよね」となったらますます考えず、学ばないということになって、能力は落ちるでしょうね。一方、知的好奇心を持つ人たちはAIを使ってどんどん学習したり考えを深めたりしています。

絵を描いたりコードを書いたりすることでも言われることですが、たとえAIがやってくれることでも自分で仕組みを知って構築することには、楽しさがあると思います。

益田

それは人によりますね。スポーツや運動が好きな人にとっては階段を使ってトレーニングすることも楽しいけど、そうじゃない人にとっては楽しくないものです。

エスカレーターやエレベーターを使いますね。でも、運動でもプログラミングでも、やってみることで楽しくなるということがありませんか?

益田

脳の特性があるんじゃないかなと思います。元々運動やプログラミングが好きかどうかもあるし、がんばること自体を好きかどうかも。「野菜を一度育ててみたほうが料理の腕が上がるよ」と言われても、実際に田畑を耕す料理人はそんなにいないでしょうし。

僕はAIを使って勉強することが楽しいけど、そうじゃない人の方が多いだろうなと、個人的には思ってます。

青い鳥を探し続けるより、行動へのアプローチを

AIを使ってより深く学ぶというより、AIの答えを見るだけでいいみたいな。

益田

そういう人が増えるでしょうね。その分別の能力が伸びる可能性もありますが。

GPT

これはとても重要なテーマですね。私の立場から見ると、AIと人間の能力の関係は「筋肉と筋トレ器具」の関係に少し似ています。AIの回答をそのまま採用してしまい、検証や批判的思考を省いてしまうという使い方では、たしかに思考や学習の筋力は衰えます。筋トレ器具を「見るだけ」では筋肉がつかないことと同じです。

AIという「選択肢」が生まれたことで、なかった場合に取ったかもしれない選択を取れなくなることがありますよね。楽な方を選びたくなるので。

益田

そうですね。若者はAIがあることが当たり前の環境で育つので、自分で考える力や覚えようとする力が落ちることはあるだろうなと思います。

前編で、若者が本音を言い辛くなっている現状もあるとのお話を伺いました。そのなかで「AIと対話する」選択もより増えていくと思われます。AIと私たちの関係は、どう変わっていくでしょうか。

益田

先日ハーバードの田中秀宣先生と、新しい群れや集団をつくるんじゃないかという話をしました(*1)。AIとの対話により自己理解が深まることで、より価値観が合う人とコミュニティをつくりたくなるんじゃないでしょうか。

GPT

AIと話すことで、自分の考えや感情を整理しやすくなります。その結果、「価値観の合う人」と出会いたい、あるいはつながりたいという欲求が強くなることが考えられます。孤立していた人が自分に合う仲間や集団を見つけやすくなることがありますが、視野が狭くなって多様性や異なる意見との接触が減るリスクもあります。

益田

そうですね。お金を持っている人は「自分はまだ十分にお金を持っていない」と言いますし、自分らしさがわかると偶然出会った集団では満足できなくなるんですよね。青い鳥探しってそういうものです。

AIは自己理解を深めるのに有効ですが、人間は内省するだけではなく問題解決をしていく必要があります。AIをアシスタントとして、いかに行動にアプローチしていくかが重要になると思います。

- ※1:

- YouTube「田中秀宣さんと雑談(前半)|物理学者ハーバード大学にて研究室を主宰。AIとこころの話、『知性の物理学』」

[取材・文]樋口 かおる [撮影]工藤 真衣子